Saut de puce : EnCharge AI veut drastiquement réduire la consommation des micro-processeurs

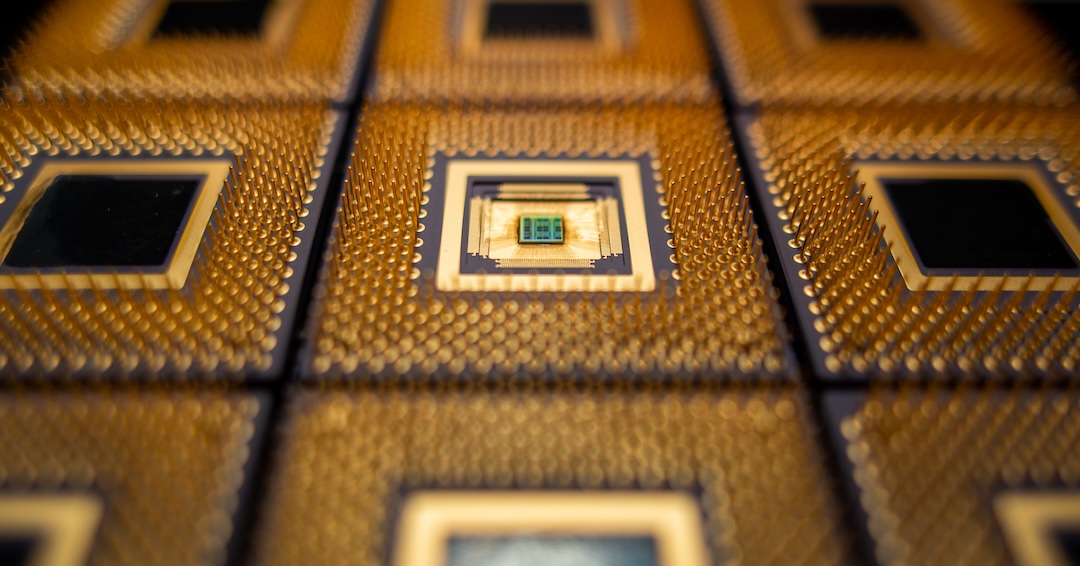

Des chercheurs de Princeton ont développé un nouveau type de puce informatique utilisant des circuits très précis qui peuvent être intégrés directement dans la mémoire de la puce. Crédit : Hongyang Jia/Université de Princeton.

Partager la publication "Saut de puce : EnCharge AI veut drastiquement réduire la consommation des micro-processeurs"

Alors que l’intelligence artificielle est adoptée de manière exponentielle dans le monde – tant pour pour des usages professionnels que par le grand public – se pose la question de la consommation d’énergie. L’IA nécessite en effet d’importantes puissances de calculs pour fonctionner. Conséquence : une forte dépense énergétique, peu compatible avec la nécessité de réduire nos émissions de gaz à effet de serre. EnCharge AI veut changer la donne avec une nouvelle génération de puce.

OpenAI, Meta, Microsoft, Stability, Google… toutes ses firmes doivent faire fonctionner un nombre croissant de centres de données de cloud computing pour répondre aux sollicitations en forte croissance des outils comme ChatGPT, Gemini, Llama, Claude, DALL-E, Midjourney ou encore Stable Diffusion. Difficile pour autant d’estimer de manière fiable la consommation globale d’électricité dans le monde générée par l’IA.

Quelle consommation énergétique par l’IA ?

À l’instar de la cryptomonnaie Bitcoin, très énergivore, l’intelligence artificielle est vorace en électricité pour fonctionner. On estime que la formation d’un grand modèle de langage comme GPT-3, par exemple, consomme un peu moins de 1 300 MWh d’électricité. C’est peu ou prou la consommation annuelle de 130 foyers américains. Ou 1 625 000 heures de visionnage de Netflix par une seule et même personne.

Alex de Vries, doctorant à VU Amsterdam, a osé une estimation en partant des données de consommation des puces Nvidia (95 % du marché de l’IA actuellement) et des prévisions de ventes du géant américain des semi-conducteurs. Selon lui, d’ici 2027, le secteur de l’IA pourrait consommer entre 85 et 134 TWh chaque année. Cela équivaut à peu près à la demande énergétique annuelle des Pays-Bas ! L’Agence internationale de l’énergie a publié des estimations assez similaires dans un rapport.

EnCharge AI : de nouveaux circuits à faible consommation d’énergie

La start-up américaine EnCharge AI, qui s’appuie sur les recherches de l’Université de Princeton, entend bousculer le marché avec un nouveau type de puce qui pourrait permettre de réduire drastiquement la consommation d’électricité. Comment ? Grâce à une technique appelée calcul en mémoire, la nouvelle architecture inventée peut stocker des données et exécuter des calculs au même endroit sur la puce, réduisant ainsi considérablement les coûts, le temps et la consommation d’énergie des calculs d’IA.

Pour éviter l’étape coûteuse – et longue – de l’échange de données entre la puce et le cloud, l’équipe EnCharge AI a conçu un nouveau type de micro-processeur informatique qui permet à l’IA de s’exécuter localement, directement sur l’appareil. Mais, pour rendre cela possible, il fallait faire en sorte qu’il ait une efficacité bien plus élevée qu’un data center. C’est là qu’entre en scène l’informatique en mémoire. Les circuits de la puce nouvelle génération sont si petits qu’ils peuvent être directement intégrés dans la mémoire de la puce. Cette approche offre une haute efficacité, un niveau de performance nécessaire aux applications modernes basées sur l’IA.

L’informatique à un tournant technologique

“Nous nous trouvons dans une position où nous repensons vraiment les principes fondamentaux de l’informatique, depuis les appareils de base jusqu’aux architectures globales”, a déclaré Naveen Verma, professeur de génie électrique et informatique et directeur du Keller Center for Innovation in Engineering Education à l’Université de Princeton. Un potentiel qui intéresse : la start-up a levé 21,7 millions de dollars auprès d’investisseurs lors de sa première ronde de financement. Au total, à date, elle a rapporté dans son escarcelle quelque 45 millions de dollars, versés par différentes sociétés de capital-risque. Sans parler d’une subvention de 18,6 millions de dollars issue de l’agence de défense américaine Darpa (Defense Advanced Research Projects Agency).

EnCharge AI compte vendre elle-même son innovation et projette de ne pas se limiter à l’intelligence artificielle. Les besoins en calculs se glissent dans de très nombreux usages et appareils. Data centers bien-sûr, mais aussi pour le secteur automobile (conduite autonome), les drones de livraison, les caisses automatiques ou encore pour les ordinateurs personnels.

SOUTENEZ WE DEMAIN, SOUTENEZ UNE RÉDACTION INDÉPENDANTE

Inscrivez-vous à notre newsletter hebdomadaire

et abonnez-vous à notre magazine.

Recent Posts

- Découvrir

Gastronomie en 2050 : ce que les chefs mijotent pour demain

Et si les chefs devenaient les éclaireurs d’un monde en transition alimentaire ? Moins de…

- Societe-Economie

Le vacarme invisible : pourquoi et comment lutter contre le bruit routier

Le bruit des transports est une pollution invisible mais bien réelle, responsable de lourdes conséquences…

- Déchiffrer

Donald Trump : Make Stupid Decisions Great Again

Justin Trudeau a qualifié la politique tarifaire de Donald Trump de « très stupide ».…

- Partager

De Sentier Valley à La Boétie Valley : la mue du cœur start-up de Paris

Une tribune d’Emmanuel Papadacci-Stephanopoli, Directeur Général Délégué, Le Village by CA Paris.

- Inventer

Surveillance des saumons par IA, élevages à terre… comment rendre l’aquaculture (un peu) plus durable

Face aux critiques croissantes contre l'aquaculture intensive des saumons, deux voies émergent pour rendre la…

- Découvrir

Sobriété : j’ai passé un hiver sans me chauffer

Et si on essayait de vivre l’hiver autrement ? Par choix plus que par nécessité,…