Partager la publication "Transcrire votre activité cérébrale en langage audio ? Meta AI y travaille activement"

En matière d’intelligence artificielle (IA), les équipes de Meta/Facebook font des étincelles. Très investies depuis de longues années dans la recherche et le développement de technologies en la matière, elles publient régulièrement leurs découvertes. Des avancées que l’on doit notamment au Français Yann Le Cun et à ses chercheurs. Le 25 août 2022, des scientifiques de la branche Meta AI du groupe, ont publié un papier scientifique passionnant sur arXiv. C’est le site de prépublications électroniques d’articles scientifiques détenu par l’université américaine de Cornell. Alexandre Défossez, Charlotte Caucheteux, Jérémy Rapin, Ori Kabeli et Jean-Rémi King ont poussé un cran plus loin le décodage du cerveau et de nos pensées.

Ils ont mis au point une solution basée sur l’intelligence artificielle capable de transcrire les pensées d’une personne. Comment ? En convertissant son activité cérébrale en langage audio en ayant recours à des outils non-invasifs. Meta AI utilise un dispositif médical doté de capteurs posé sur le crâne capable “d’écouter” l’activité cérébrale. Celle-ci se traduit par des variations de champs électromagnétiques qui sont ensuite décodées et transformées en langage sonore. Bref, des phrases pensées sont traduites puis “lues” en format audio.

169 cobayes volontaires pour scanner leur cerveau

Concrètement, Meta AI a fait appel à 169 personnes volontaires pour servir de cobaye lors de cette expérimentation. Ces individus ont enfilé un bonnet m-EEG (électroencéphalographie mobile) doté d’électrodes posées sur le crâne. Le dispositif a enregistré leur activité cérébrale pendant qu’ils écoutaient des phrases en langage naturel. Il s’agissait de phrases construites issues de livres audio et de phrases isolées en anglais et en allemand. Cela va donc bien au-delà de simples mots mis bout à bout.

Derrière, un réseau de neurones (intelligence artificielle) analysait les variations électriques et magnétiques pour en dégager des motifs connus. Ces patterns étaient identifiés grâce à un apprentissage de l’IA, baptisée wav2vec 2.0, basée sur 600 heures de lectures audio. Ce processus permettait de traduire ces ondes en concepts/mots. Puis ces représentations étaient ensuite reconverties en pistes audio intelligibles.

On avait donc des phrases lues et écoutées par les cobayes. Puis un enregistrement de leur activité cérébrale. Ensuite une analyse par l’intelligence artificielle de cette activité. Et enfin une traduction en paroles. Il ne restait plus ensuite qu’à écouter et à comparer les phrases initiales avec celles obtenues au terme du processus.

Un taux de réussite allant jusqu’à 73 %

Au total, l’intelligence artificielle a analysé quelque 150 heures d’enregistrements à l’aide de son outil de décodage du cerveau. Résultat de l’expérience ? “À partir de trois secondes d’activité cérébrale, nos résultats montrent que notre modèle peut décoder des segments de parole. Avec jusqu’à 73 % de précision à partir d’un corpus de 793 mots. C‘est-à-dire une grande partie des mots que nous utilisons le plus souvent au cours d’une journée”, explique Meta AI.

“Ces décodeurs cérébraux ont été entraînés sur un petit nombre d’enregistrements pour prédire un ensemble limité de caractéristiques de la parole. Telles que des catégories de parties du discours ou des mots d’un petit vocabulaire. Pour nos recherches, nous avons conçu une nouvelle couche d’intégration de sujets. Celle-ci est entraînée de bout en bout pour aligner tous les enregistrements cérébraux dans un espace commun”, explique Meta AI sur son blog. Au-delà de simples mots isolés identifiables par l’IA, l’équipe de scientifiques a donc passé un cap pour pouvoir décoder des phrases complètes.

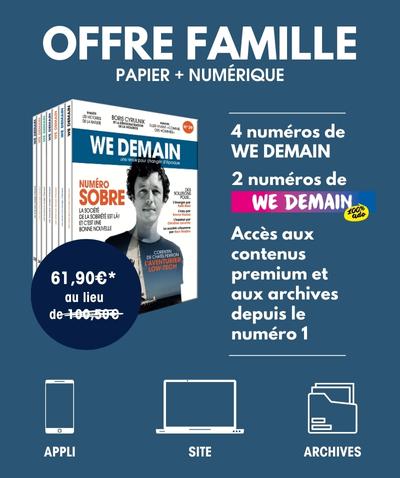

SOUTENEZ WE DEMAIN, SOUTENEZ UNE RÉDACTION INDÉPENDANTE

Inscrivez-vous à notre newsletter hebdomadaire

et abonnez-vous à notre magazine.