Partager la publication "Comment utiliser Mistral, l’IA française, en local sur son PC avec Nvidia"

Ce n’est encore qu’une application en démo, mais le principe est pour le moins intéressant. Voici quelques jours, le fabricant de puces américain Nvidia a dévoilé un nouvel outil en téléchargement gratuit. Il s’agit de Chat with RTX, un logiciel à installer sur son ordinateur et qui permet de tester de l’intelligence artificielle – en l’occurrence le modèle maison de Nvidia, LLaMA 2 de Meta ou l’IA française Mistral AI – sans mettre en péril sa vie privée et ses données. Seule condition impérative : posséder un PC doté d’un processeur graphique (GPU) Nvidia (séries RTX 30 et RTX 40 disposant d’au moins 8 Go de VRAM sous Windows 11).

Comment fonctionne cette solution qui permet de construire son propre chatbot personnalisé ? Une fois installée sur un PC, il suffit de lancer l’application et de lui demander, par exemple, d’analyser un fichier PDF ou un ensemble de documents présents dans un dossier. Il ne vous reste ensuite plus qu’à interroger le chatbot pour en extraire les informations et données dont vous avez besoin. Tout cela se passe sur votre ordinateur, donc avec une consommation de ressources bien moindre que si vous utilisez ChatGPT et ses services dans le cloud de Microsoft.

Une bonne option pour la protection des données

Cette solution locale nécessite d’avoir de l’espace libre sur votre machine. Comptez entre 40 et 100 GB en fonction du modèle d’intelligence artificiel choisi. Et 3 Go de RAM. En laissant le choix d’utiliser, outre sa solution propriétaire, LLaMA 2 de Meta ou l’IA française Mistral AI avec Chat with RTX, Nvidia a opté pour des modèles de langage open-source. Pour l’heure, en utilisation locale, sans nécessité de connexion internet, les seuls formats acceptés sont : .txt, .pdf, .doc, .docx et xml. Parfait pour analyser des fichiers sensibles (personnels ou professionnels) sans avoir à les partager avec une IA aux politiques de confidentialité laxistes. En mode connecté, il est possible de résumer par exemple des vidéos YouTube.

Les premiers tests sont relativement convaincants, permettant d’extraire des données ou de créer des synthèses pertinentes sur une large quantité de données. Y compris issues de PDF, ce qui est souvent le point faible d’autres IA connectées, comme ChatGPT ou Copilot de Microsoft qui sont parfois à la peine avec ces formats de documents. En revanche, les résultats sont bien plus versatiles concernant l’analyse de vidéos YouTube. En outre, Chat with RTX ne possède pas de mémoire contextuelle, ce qui oblige parfois à de longues formulations des prompts (requêtes) pour obtenir les réponses attendues.

L’occasion de tester Mistral AI, l’IA made in France

Chat with RTX est aussi une solution pour tester l’intelligence artificielle générative française Mistral AI. Fondée en mai 2023 par trois Français — Arthur Mensch, Guillaume Lample et Timothée Lacroix –, la start-up, qui défend une logique d’open-source depuis ses débuts. Elle a développé une architecture qui comporte 45 milliards de paramètres au total. Et revendique de surpasser sur la plupart des tests d’autres IA, dont GPT-3.5 (la version gratuite de ChatGPT d’OpenAI).

Sa dernière itération en date, Mixtral 8x7B, est, selon Mistral, “six fois plus rapide que Llama 2 70B sur tous les benchmarks”. Elle “parle de nombreuses langues et possède des capacités naturelles de codage”. En outre, les fondateurs estiment posséder la meilleure IA “en ce qui concerne les compromis coût / performance“. Autre avantage : la possibilité d’adapter le modèle de langages de Mistral AI pour son entreprise pour un usage interne plus adapté et à la sécurité renforcée. Chat with RTX permet déjà d’avoir un aperçu des performances de l’IA française. Un bon point.

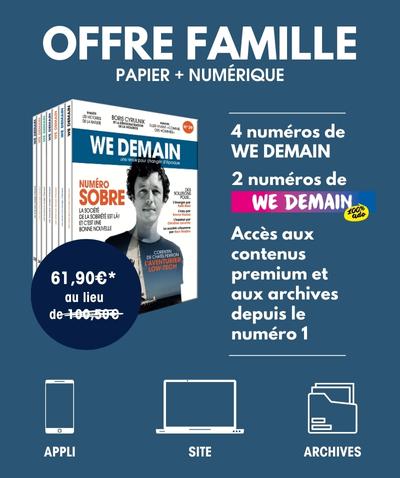

SOUTENEZ WE DEMAIN, SOUTENEZ UNE RÉDACTION INDÉPENDANTE

Inscrivez-vous à notre newsletter hebdomadaire

et abonnez-vous à notre magazine.