Partager la publication "Travail, fraude, RH… intelligence artificielle mais risques réels"

L’intelligence artificielle (IA) semble être à la fois source d’opportunités et de menaces pour le futur. Du côté des opportunités, l’homme a toujours cherché à automatiser les tâches physiquement pénibles et/ou répétitives. L’individu est ainsi plus productif et est capable d’utiliser sa propre capacité intellectuelle pour d’autres activités plus stimulantes. L’IA permettra d’aller plus loin dans ce processus. Du côté des menaces, on retrouve globalement la peur de l’inconnu et toutes les insécurités qu’il génère.

L’intelligence artificielle (IA) fait référence à des machines conçues pour effectuer des tâches similaires à l’intelligence humaine, interpréter les données externes, apprendre de ces données externes et utiliser cet apprentissage à s’adapter aux tâches pour obtenir des résultats spécifiques et personnalisés.

Faut-il interdire ChatGPT et craindre le pire pour la suite ?

Récemment, le focus médiatique autour de ChatGPT, attise les hardiesses et les peurs. Si bien que des pays comme la Chine ou l’Italie ont récemment décidé de limiter voire d’en interdire l’usage. Des voix s’élèvent également en France où ChatGPT a été interdit dans un certain nombre d’établissements universitaires. Des élus réclament aussi son interdiction au parlement.

Cet outil donne une idée de la puissance potentielle de l’intelligence artificielle. En effet, avant ChatGPT, l’automatisation était essentiellement liée à la robotisation des tâches manuelles. ChatGPT pourrait en revanche remplacer l’intelligence humaine. Une étape importante semble donc franchie.

Intelligence artificielle : des risques multiples

Dans ce contexte, nous avons mené une recherche pour identifier les différents risques liés à l’essor de l’IA. Ils sont de plusieurs types : les risques managériaux, risques opérationnels, risques au sein du marché de travail, risques d’autres clivages sociaux et les risques de concurrence mondiale.

Les risques managériaux principaux sont liés à la responsabilité humaine dans la décision et de la dépendance humaine aux outils d’analyse de données. Le manager prend des décisions en se basant sur les informations générées par les outils d’IA. Qui est responsable si les résultats donnés par l’outil numérique sont faux et que le manager en conséquence a pris une mauvaise décision ayant des implications lourdes ? Un exemple peut être les études de marchés développés par ChatGPT avec des recommandations plausibles mais basées sur de mauvaises informations et sur lesquelles s’appuieraient des décisions managériales.

Les risques opérationnels sont eux essentiellement liés à la sécurité et à la fraude. D’un côté, l’IA pourrait aider à améliorer la sécurité des transactions financières, mais il peut aussi augmenter le pouvoir de nuisance des fraudeurs. En effet, cette numérisation extrême constitue un terrain propice aux cyberattaques. Un outil d’IA peut par exemple imiter la voix d’un tiers de confiance et obtenir ainsi des informations confidentielles. ChatGPT pourrait même étudier et permettre de briser les pare-feux des entreprises.

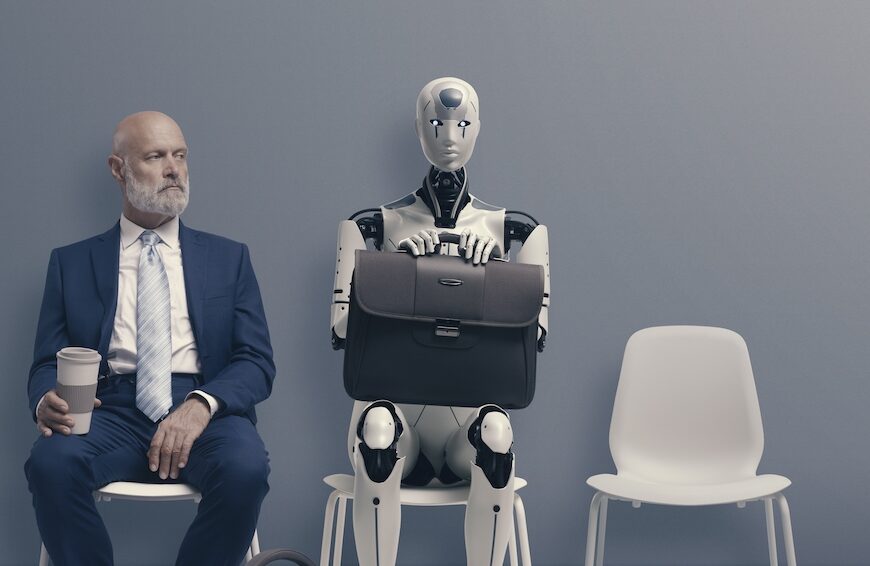

Les risques au sein du marché de travail sont liés au possible remplacement de certains métiers par l’IA. Jusqu’à récemment, les craintes étaient liées aux métiers des cols bleus mais désormais ces craintes se portent sur les cols blancs. Par exemple, les textes écrits dans n’importe quel domaine, des problèmes complexes de mathématiques, des programmes informatiques peuvent à présent être effectués par ChatGPT, bien qu’une intervention humaine soit souvent requise pour finaliser les résultats. Ces compétences pourraient donc remplacer beaucoup de métiers à terme. Pour qu’elle fonctionne mieux, l’IA doit pouvoir discerner les données produites par des experts fiables de celles produites par d’autres.

À propos des auteurs :

Vipin Mogha. Enseignant-Chercheur en Finance et Entrepreneuriat, ESCE International Business School.

Arvind Ashta. Professor Finance and Control, Burgundy School of Business.

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.